最能人工智能ChatGPT⑷,就是冲着赚钱来的

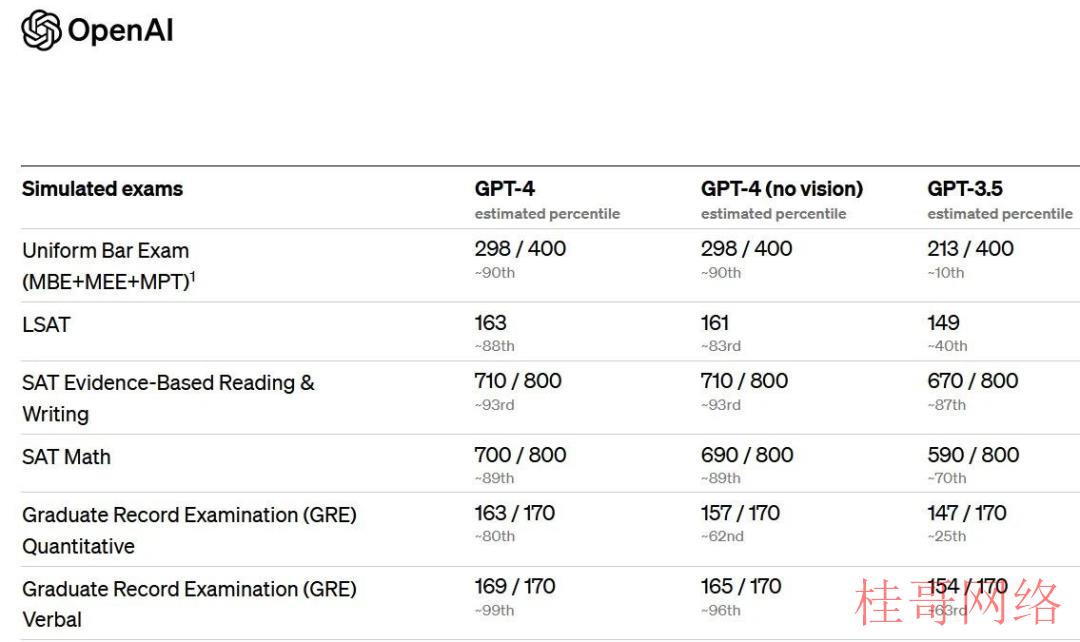

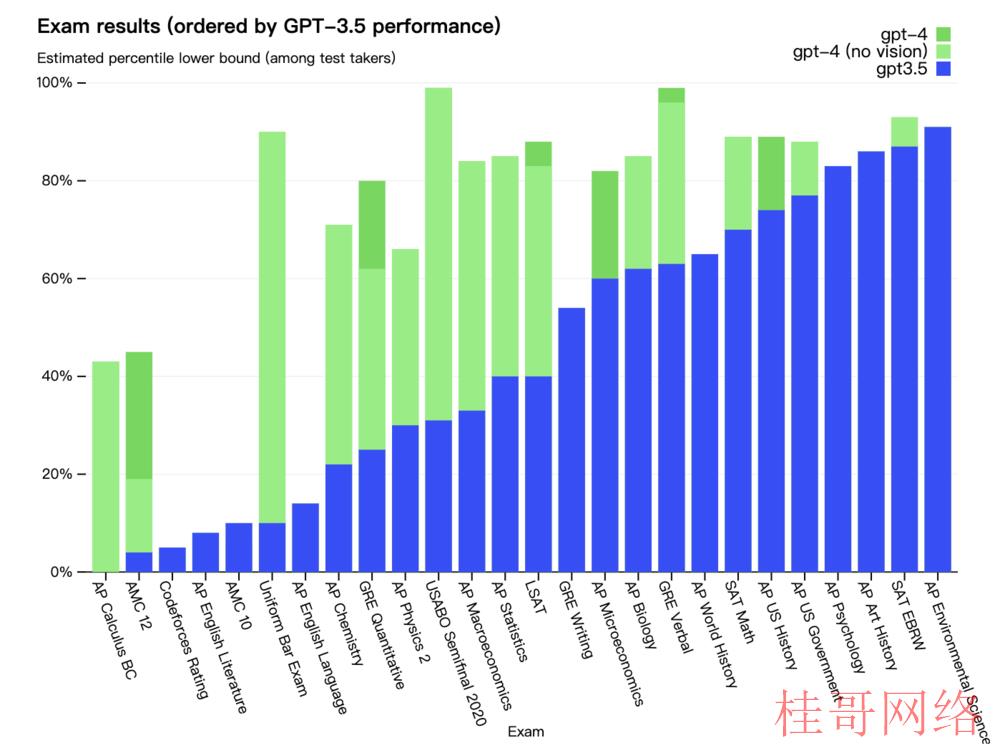

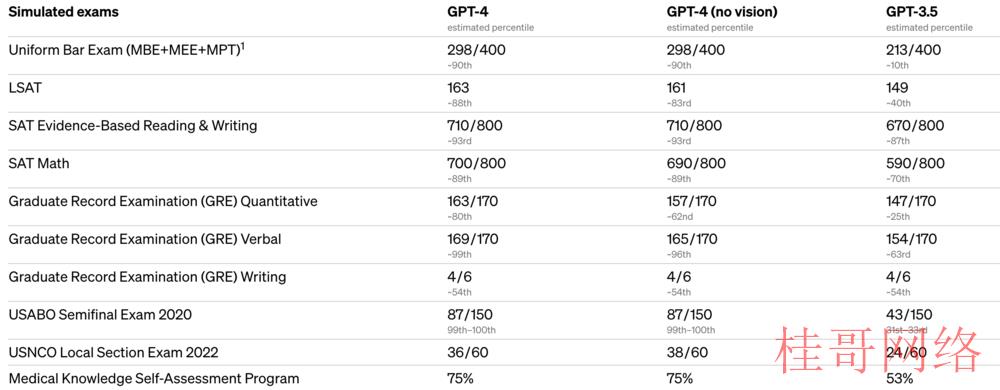

据OpenAI介绍,虽然GPT⑷在许多现实世界的场景中能力不如人类,但在各种专业和学术基准上能够表现出人类水平的性能。

chatgpt中文版 http://chatgpt.guige.xyz

目前官宣的GPT⑷能力与此前传说的基本类似,主要提升了语言模型方面的能力,并添加了“多模态”的图片辨认功能。

另外,GPT⑷ 将“单词*输出限制”提高到了 25000个单词,比基于GPT⑶的ChatGPT更强大,在对问题的理解和回答方面,GPT⑷也显得更聪明,更像人了。

目前,ChatGPT Plus版本的用户已可以直接在原来的ChatGPT基础之上,选择GPT⑷模型,直接体验。不过,目前GPT⑷每4小时只能回答100个问题。

ChatGPT Plus已可以适用GPT⑷了

在前不久的GPT⑷“谎言”阶段,微软就曾屡次通过各种渠道透出New Bing会*时间利用GPT⑷。新模型发布后,微软更是在*时间宣布“我们很高兴确认新的Bing正在运行GPT⑷,我们已为搜索进行了定制。如果您在过去五周中的任什么时候候使用了新的Bing预览版,那末您已体验到了这个强大模型的初期版本。”

在参数量方面,在OpenAI公布的GPT⑷论文中,并没有之前一直传说的“100万亿参数”,乃至没有提及GPT⑷到底用了多少参数,不过笔者亲测ChatGPT Plus中开放的GPT⑷功能后感觉,回答的速度比GPT⑶.5要慢了一些。

“单从回答速度比ChatGPT慢来讲,其实不能表明GPT⑷的参数量就更大。”大算力AI芯片存算一体专家,千芯科技董事长陈巍博士认为,OpenAI不公布参数量和架构是一种商业化技术保护策略,增加其竞争对手的产品试错本钱。不过目前也没法排除GPT⑷参数量小于GPT⑶的可能性。

迅速落地商业利用,保密参数量,增加图片辨认能力,大幅提升语言模型能力。GPT⑷的推动速度,比4个月前的ChatGPT快了不是一步两步。

相较于之前的版本,GPT⑷ 更具创造性和协作性。它可以生成、编辑并与用户一起迭代创意和技术写作任务,例如创作歌曲、编写剧本或学习用户的写风格格。直接把1万字的程叙文档Ctrl+C、Ctrl+V一股脑扔给GPT⑷就行,短短几秒即能得到解决办法。

从ChatGPT问世到GPT⑷发布前的这4个月时间里,对GPT⑷最多、最准确的预言就是“多模态”,简言之就是GPT⑷可以看图了,而且它还可以看懂图片的内涵。

在自然语言处理(NLP)中,文本、图象和音频信息都可以共同帮助理解和生成更丰富的内容。一样,在计算机视觉任务中,文本和图象信息“齐发”可以提高目标检测和场景理解的准确性。

“具有多模态的生成能力一定是大模型未来的趋势,而且生成式大模型不是只能做图象生成、文本生成这样的生成任务,它实际上是有望成为未来AI的统一底座的。”瑞莱智慧副总裁唐家渝举例说,生成式模型在解决零样本、少样本学习任务时也有着优良的表现,这也是研究生成式大模型的重要意义之一。

GPT⑷本次发布最冷艳的地方就在于,AI对“看”这件事儿,不再只是关注眼前事物,而是可以理解图片的含义了。

商业化能力再提升,GPT⑷能去赚钱了?

“GPT⑷已突破了落地的问题,采取云的方式,用的人越多,本钱越低。”云舟集成电路开创人兼CEO赵豪杰认为,GPT⑶会更偏向NLP,而GPT⑷在各方面的能力都更强一些。他给虎嗅举了这样一个例子,GPT⑶就像初中生,还不能出来工作赚钱,GPT⑷应当已职校毕业,可以上班赚钱了。

GPT⑷的能力虽然在很多现实场景中不如人类,但在各种专业和学术基准测试中表现出了与人类相当的水平。不管怎样说,GPT⑷确切在商业化上更进一步了。

对GPT⑷在专业技能上的突破,如果再进一步思考,也许未来人类的职业技能,将被AI重构。而在教育和技能培训方面,也许现在就该开始思考,哪些技能AI没法取代,我们应当学习甚么知识和技能,以保持身为“人类”的不可替换性。

相比于GPT⑶和GPT⑶.5,GPT⑷的智力更强,更不容易出错,这明显有益于商业落地,而新增的图片辨认功能则给OpenAI找到了更多的利用场景。

GPT⑷能够基于视觉信息做逻辑推理,不但告知用户眼前产生了甚么,更能说动身生的事代表了甚么。目前,OpenAI已给GPT⑷找到了一个社会价值非常高的利用场景——助残。

BeMyEyes 是一家总部位于丹麦的公司,他们致力于在平常生活中帮助视障人群。BeMyEyes的基础功能是在App中招募,通过链接志愿者和视障人士,为他们提供“视力”帮助。

OpenAI 此次公布GPT⑷时,也公布了他们和BeMyEyes的密切合作,通过GPT⑷的多模态辨认功能,为视障人士提供更便捷的“虚拟志愿者”(Be My Eyes Virtual Volunteer™)。用户可以通过该利用程序将图象发送给给予GPT⑷的“虚拟志愿者”, AI将为各种任务提供即时辨认、解释和对话式的“视力”帮助。

目前该功能正处于封闭测试阶段,预计将在接下来的几周内扩大 Beta 测试人员群体,并有希望在未来几个月内广泛提供虚拟志愿者。该利用在中国App Store亦可下载中文版本,目前也已开放了公测排队。Be My Eyes宣称“该工具将对所有使用 Be My Eyes 利用程序的盲人和低视力社区成员不要钱。”

“真实的多模态大模型还没有来,期待GPT⑷.5和GPT⑸,还会在多模态上有很大进展。”源码资本履行董事陈润泽告知虎嗅,多模态大模型还有很大发展空间,未来也会带来更多的利用场景。

桂{哥{网{络www.gUIgeGe.cn

本文来源于chatgptplus账号购买平台,转载请注明出处:https://chatgpt.guigege.cn/jiaocheng/29950.html 咨询请加VX:muhuanidc