chatgpt中文版 http://chatgpt.guige.xyz

相信大家都听过chatGPT, DO君最近终究用上了chatGPT。最近通过网上各种资料,尝试弄明白到底GPT背后做了啥(通俗的原理解释),其次作为一个AI产品经理,GPT对工作的启发,未来几篇也集聚焦分享跟AI动态。

作为一款人工智能产品,这是一个‘iphone'时刻,对照之前的Siri还有各种语音助手,他们简直弱爆了。另外一个奇异的地方是我之前对人工智能的理解,是for特定一个任务训练一个模型,比如人工智能上一个奇异时刻,就是2016年alphaGO碾压人类选手,但是它只会下围棋,离我们普通人也比较远。

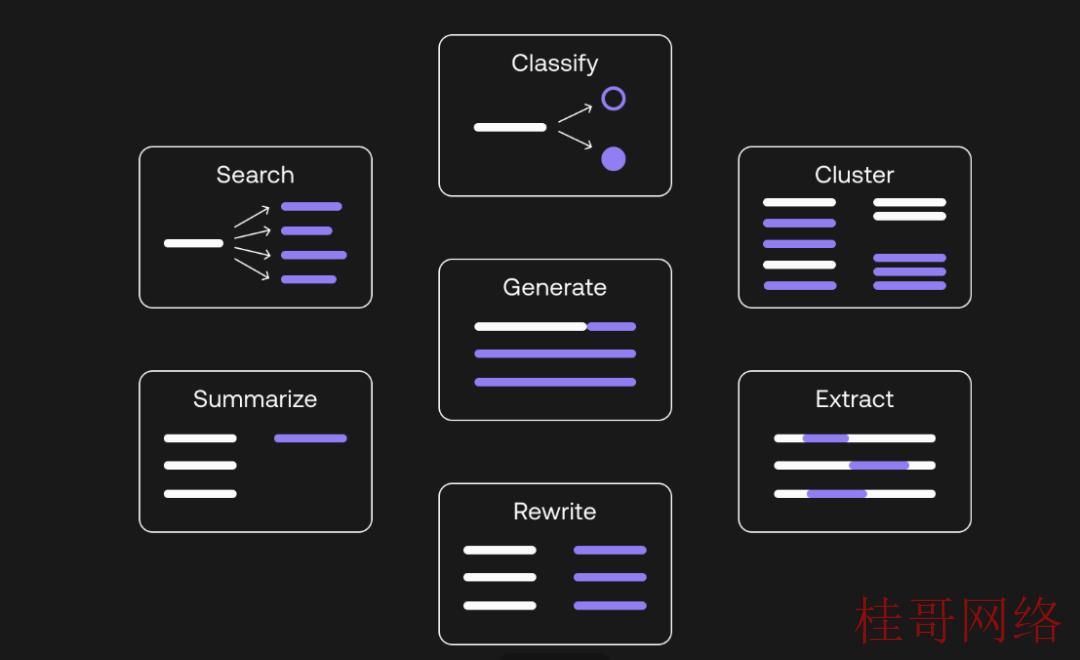

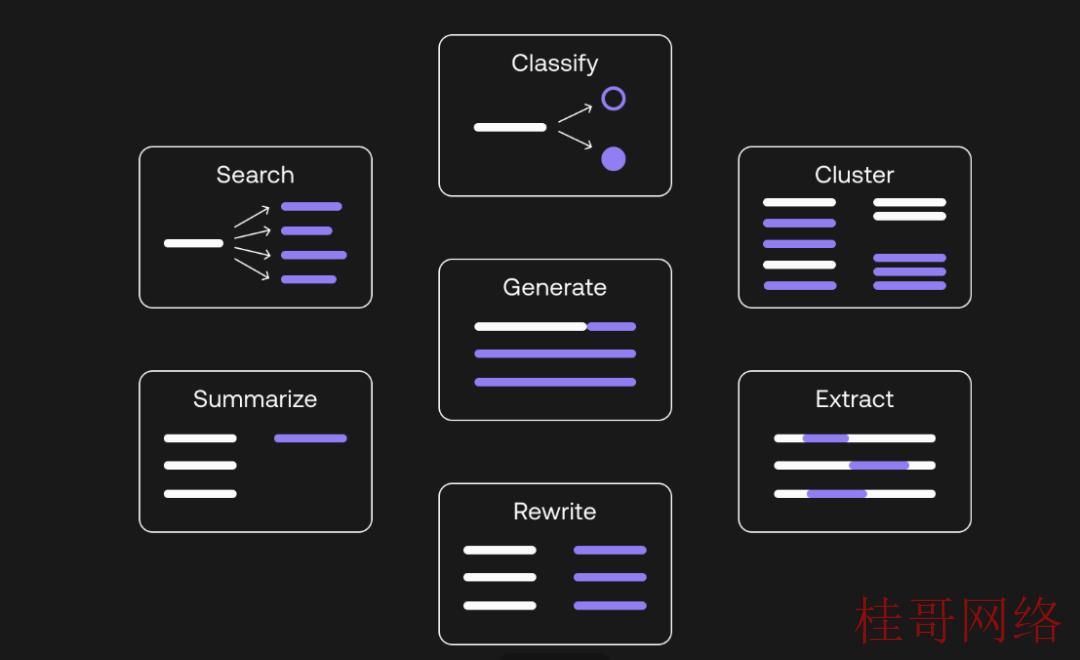

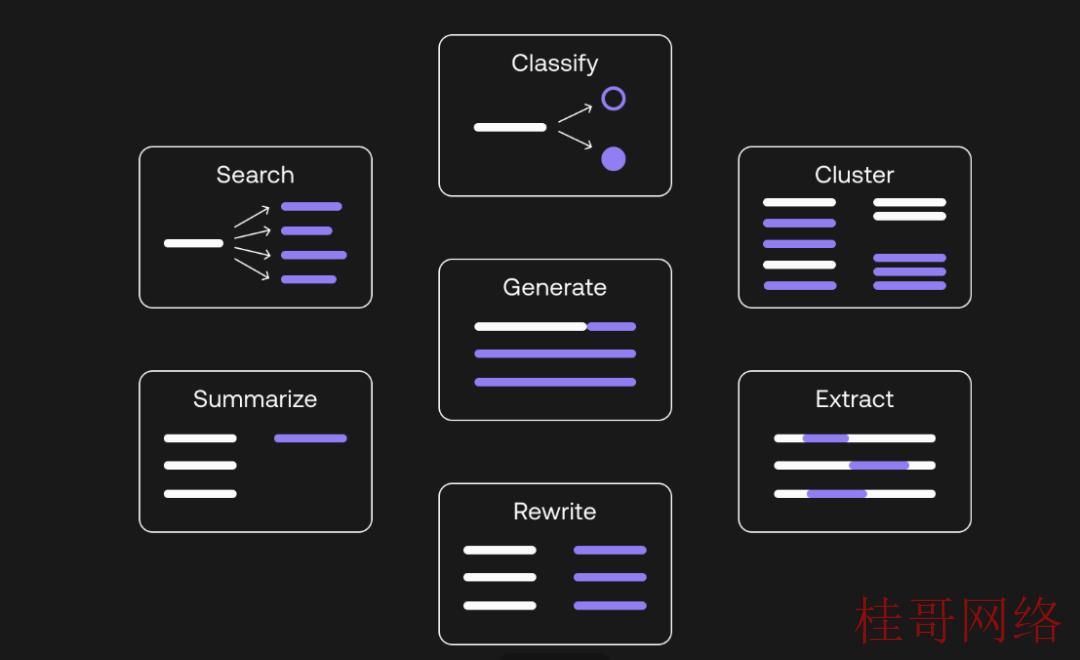

chatGPT可以实现多任务通用的自然语言理解,既可以聊天,也能够做机器翻译,做题目,总结摘要,写代码,搜索,写故事与论文等(相当于做了一个通用的模型,会干区别类型的活)。

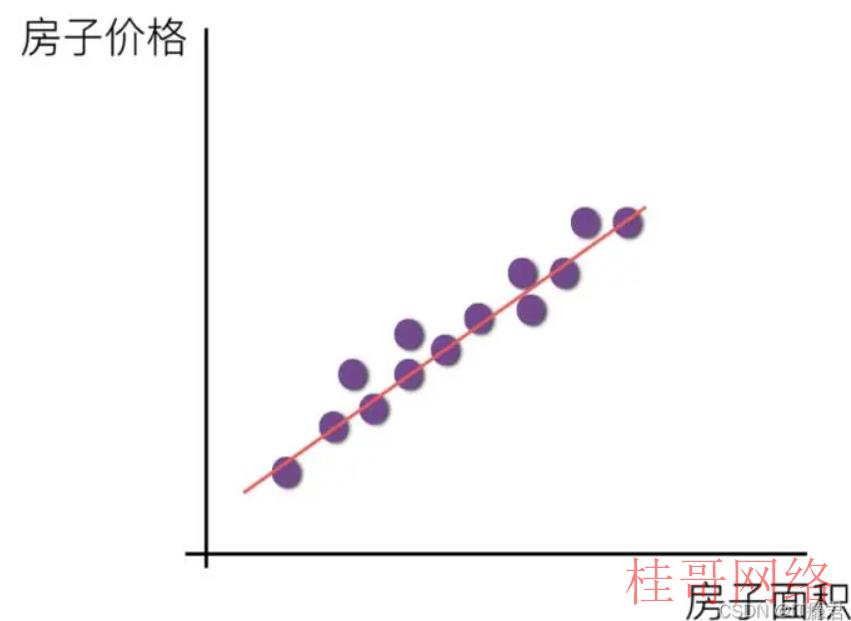

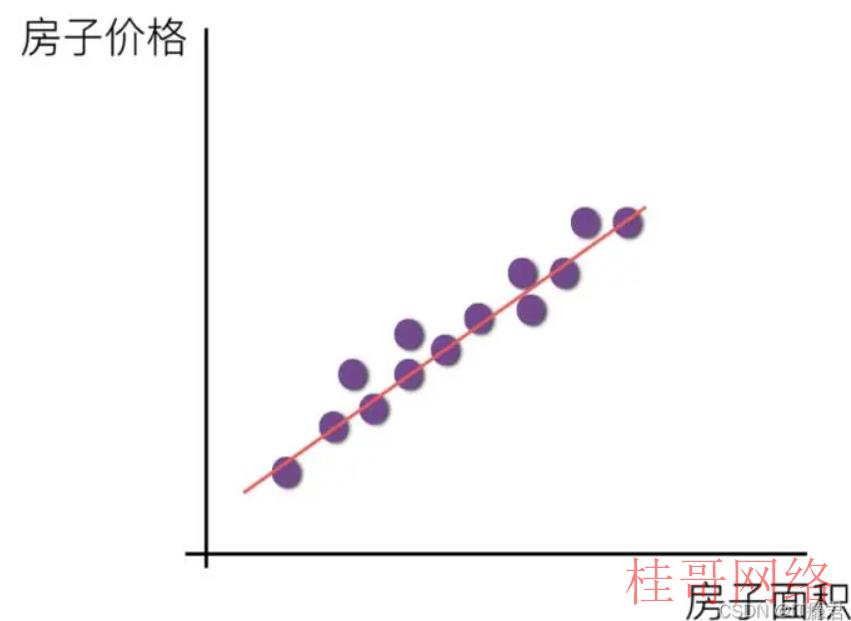

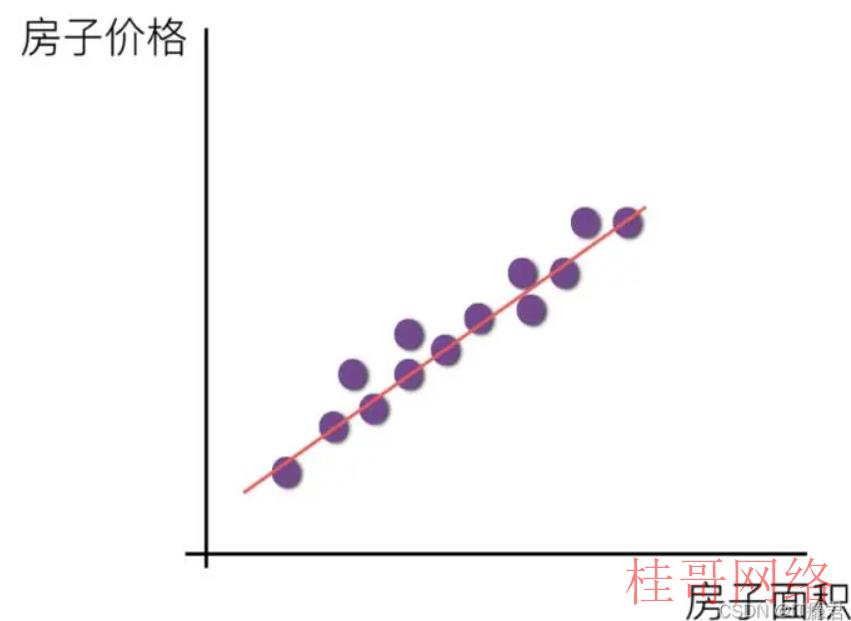

GPT的全称是(Generative Pre-trained Transformer),是一种基于 Transformer 模型的预训练语言模型(也称之为大语言模型LLM)。你肯定奇怪都是啥,看不懂,接下来为你逐一拆解。数百万或数十亿个参数的深度神经网络模型,这类模型经过专门的训练进程,能够对大范围数据进行复杂的处理和任务处理。简单理解甚么是模型的参数呢?大家都学过的简单的线性模型,即y = ax + b, 其中a和b是模型的参数,一个特定的a,b意味着一个拟合的特定直线。

目前在各行各业里AI模型利用场景,通常为用自己独有的小数据集,训练得到一个特定参数的小模型,区别的场景就单独训练,区别公司也单独训练,本钱蛮高的。而预训练语言模型的期望是训练得到一个通用的'万能'模型,后期利用只需要低本钱的微调就能够。OPENAI的愿景就是:“有一个任务无关的超大型LLM,用来从海量数据中学习各种知识,这个LLM以生成一切的方式,来解决各种各样的实际问题“。(1)预训练:基于大范围文本,无监督预训练得出通用的语言表示(得到一套通用的模型参数)(2)微调:通过有监督微调的方式,将学习到的知识传递到区别的下游任务中(微调对应的参数适应区别的任务)。

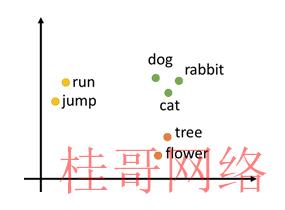

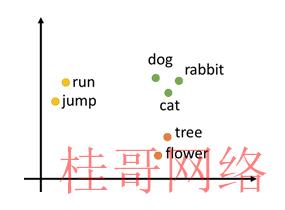

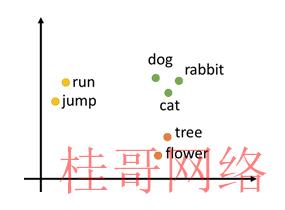

-语言模型是干甚么的,Transformer语言模型是新的技术吗?语言是离散的符号,自然语言的表示,就是将人类的语言表示成更容易于计算机理解的方式。这里就用到了语言模型,将文本进行向量化。

2013年,第一代预训练模型,单纯基于单词判断类似(word2vec和GloVe)。可以理解为每一个单词有一个固定的向量表示,语义相近的单词,向量是类似的。问题是一词多义没法解决,没有上下文理解。比犹如一个词play可以玩球,玩乐器,播放音乐/视频等。2017年,第二代预训练模型。谷歌大脑团队在2017年的论文《Attention is all you need》中首次提出Transformer模型(最初6500参数),本身将单词和其上下文顺序以数字情势斟酌进去,训练模型,所以其实不是一个新技术。

-为何是OPEN AI不是AI领头羊google?他们是采取了transformer的2个技术分支,GPT与BERT采取了区别的技术线路。

简单理解,BERT是一个双向模型(3亿参数),可以联系上下文进行分析,更善于“完形填空”;而GPT是一个单项模型(生成式,Generative),只能从左到右进行浏览,更善于“写作文”。GPT⑴的效果还不如Bert, 但是GPT⑵性能上开始超出Bert。这个方向一路走到黑的秘诀是甚么?

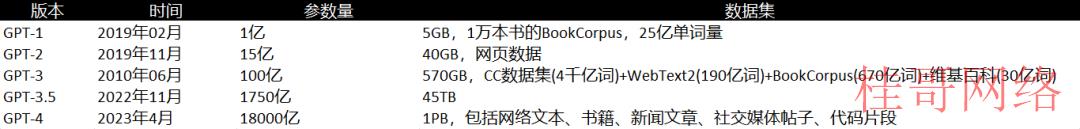

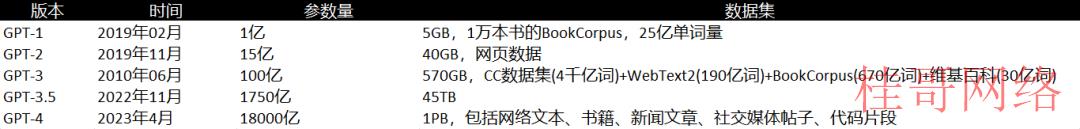

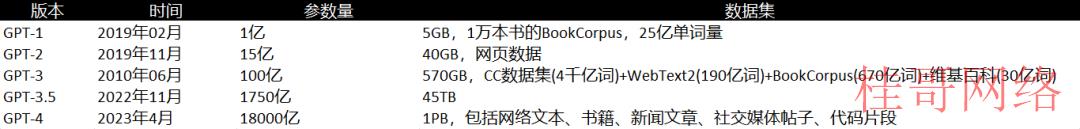

相对来讲,大力出奇迹这句话再适合不过了。通过下表,可以看到模型参数量,喂的数据量都是指数级增长。GPT⑵的参数15亿已超过了Bert的3亿参数了。

-突破了之前对工作中模型方法的认知。之前方法是举得针对特定的场景需要训练特定的模型效果才会好,其实跟据第一性原理,只要模型参数够多,理论上大部份场景可以cover的大模型。-其次是大模型的训练本钱很高,很多时候不需要自己从头到尾开发一个模型,可以斟酌最节省本钱的方式,利用已有的开源大模型来进行idea的效果验证,加快迭代的步伐。-一般意义上无监督很难利用到真实产品中(一般无监督的结果不可控),但是无监督和有监督组合的方式,打开了新思路。-内容创造的一切皆可AI化。可以利用其它内容与文本之间关联,间接生成图象/语音/视频/音乐等。-数据分析行业来讲,data etl和insight 和dashboard都可以被GPT辅助。-对数据依赖比较强,其实大的互联网平台公司,比如天猫,会不会很容易用大模型实现行业大模型。特定行业数据的大模型机会点,比如在服装换装方面。

-注册用海外邮箱,建议google邮箱,不要用国内邮箱,容易被封了;

-然后需要外国手机号和验证码,可以花2美元在这个网站上注册以后充值,然后找OpenAI的选一个国家的号码。

- 然后复制这个号码和验证码,就能够验证成功了。

——END ——

桂#哥#网#络www.gUIgege.cn

本文来源于chatgptplus账号购买平台,转载请注明出处:https://chatgpt.guigege.cn/jiaocheng/29834.html 咨询请加VX:muhuanidc