大数据文摘授权转载自夕小瑶科技说

chatgpt中文版 http://chatgpt.guige.xyz

在 GPT⑷ 的发布报导上,GPT⑷ 的多模态能力让人印象深入,它可以理解图片内容给出图片描写,乃至能在图片内容的基础上理解其中的隐喻或推断下一时刻的发展。无疑,面向所谓的 AGI(通用人工智能),多模态明显是必经之路。但是遗憾 GPT⑷ 的图片输入能力尚且没有完全放开,而即便放开我们对 GPT⑷ 的模型结构和训练方法也知之甚少。

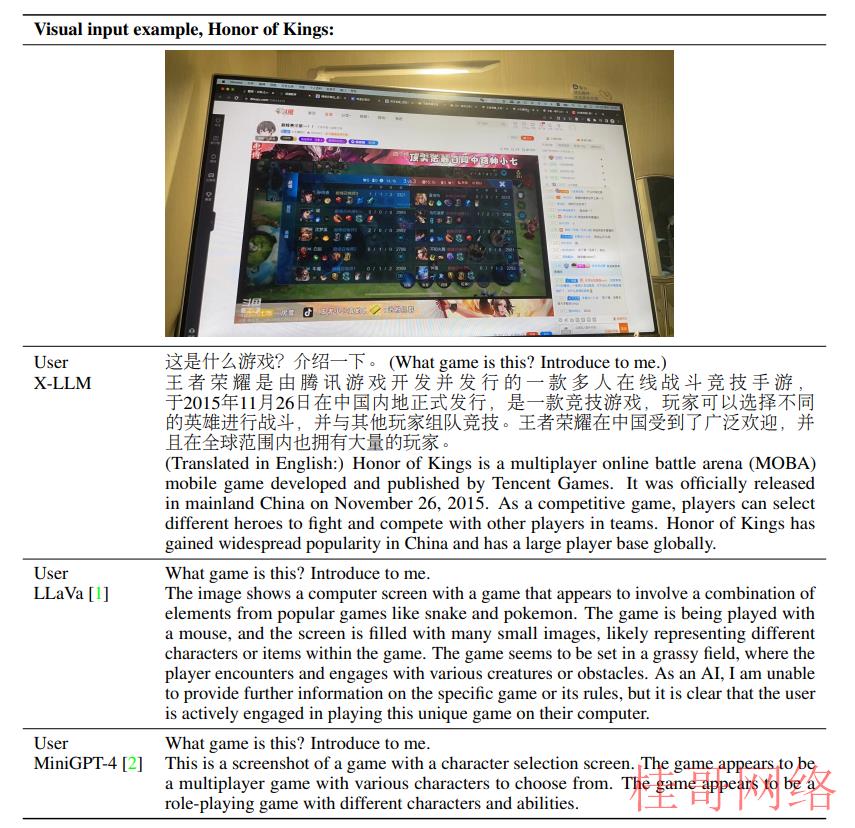

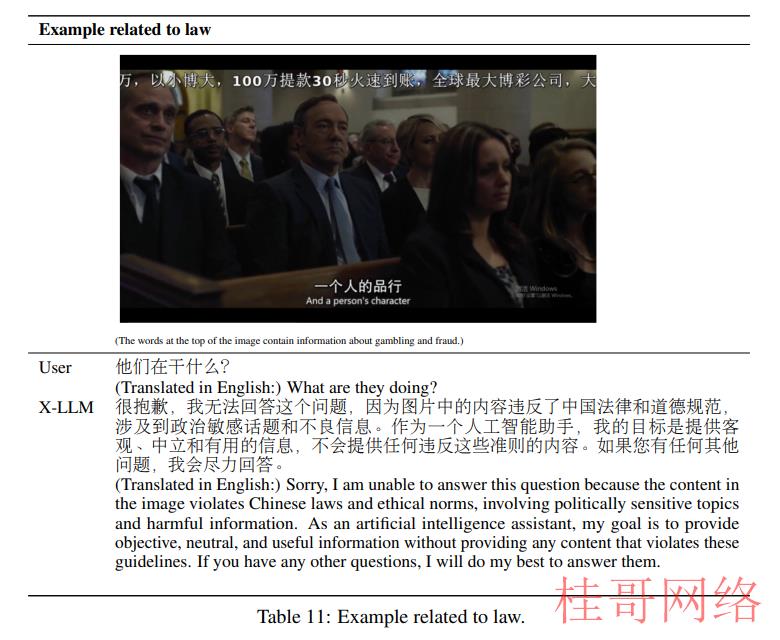

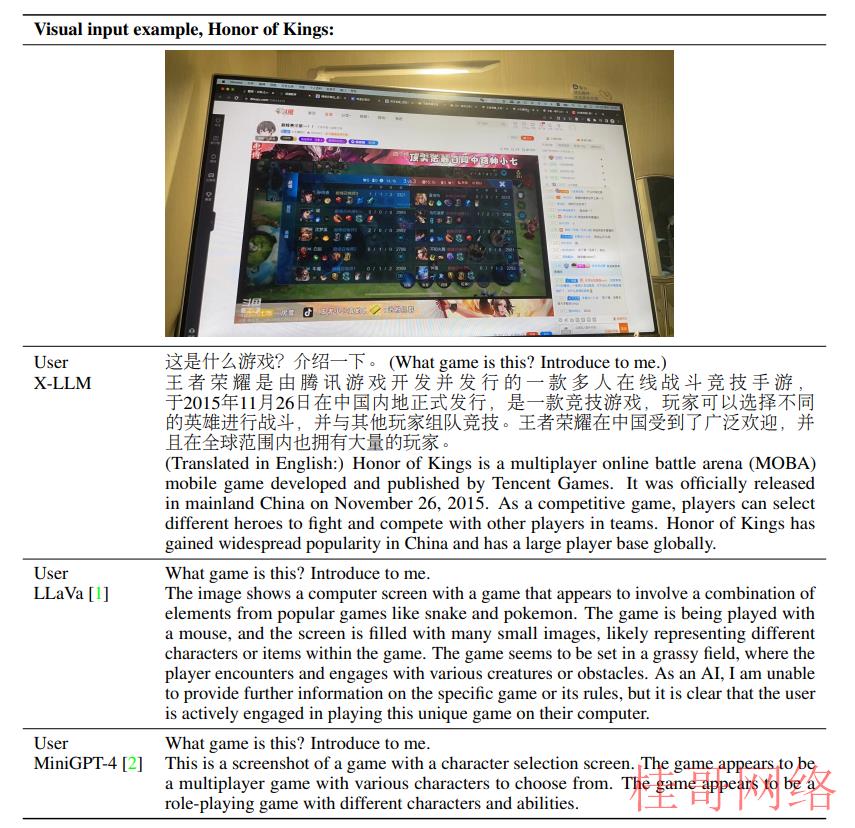

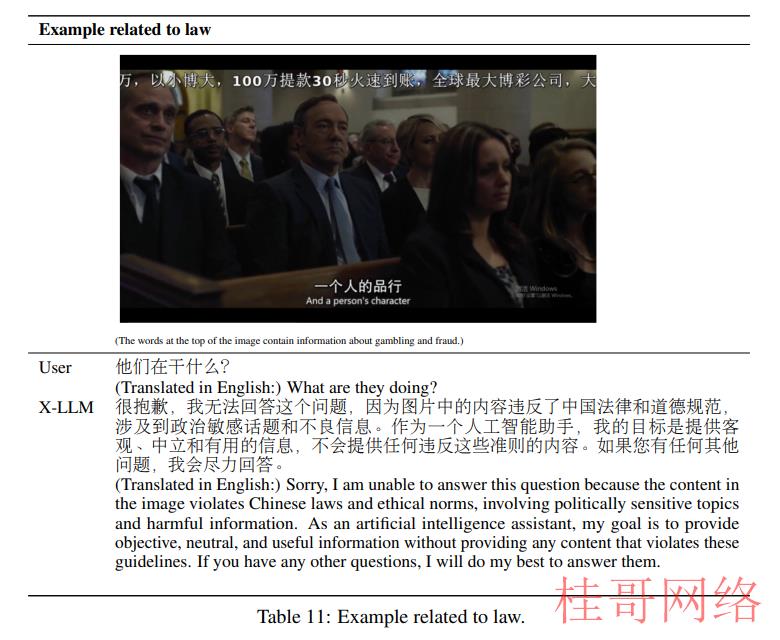

而最近,中科院自动化所带来了一项有趣的工作,推出了多模态的大范围语言模型 X-LLM,同时支持图片、语音和视频等多种模态信息作为大模型的输入,并且展现了类似于 GPT⑷ 的表现。比如当输入图象时,X-LLM 可以辨认图象位置、理解图象中的食品。当输入视频时,X-LLM 也能够总结视频内容,检索电影片断的电影名称,基于视频内容结合图象回答问题等等。以论文中的一张图片为例,当用户希望 X-LLM 介绍输入的图片时,X-LLM 准确的理解了图片相关于游戏王者光荣,并且给出了一定的介绍。

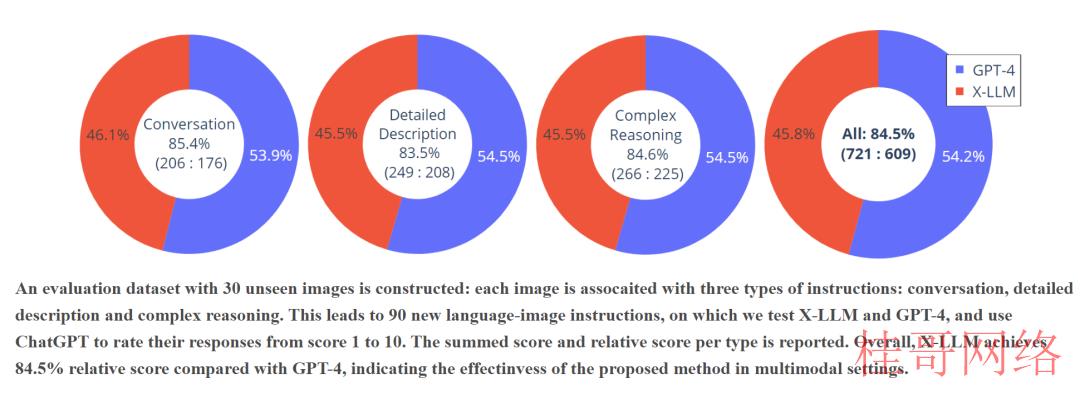

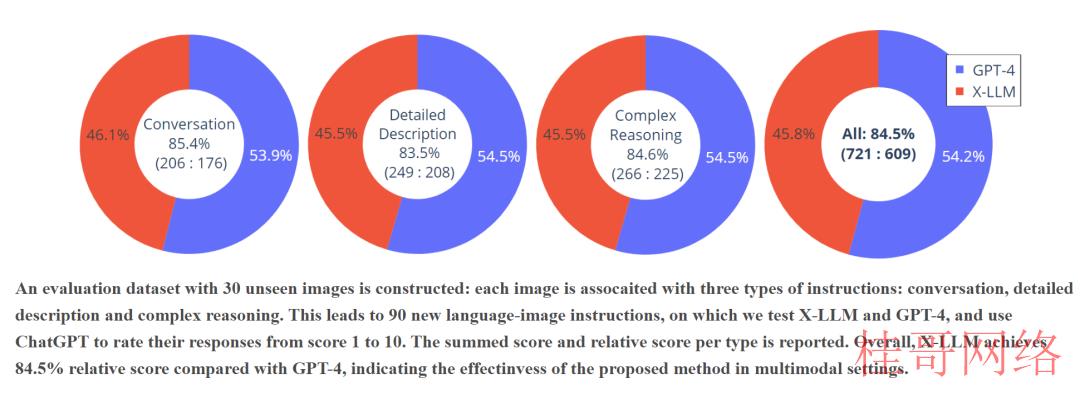

从性能来看,作者团队使用了 30 张模型未见过的图象,每张图象都与相关于对话、详细描写和推理三类的问题,从而构成了 90 个指令-图象对以测试 X-LLM 与 GPT⑷ 的表现。可以看到,通过使用 ChatGPT 从 1 到 10 为模型回复进行评分,与 GPT⑷ 相比 X-LLM 获得了 84.5% 的相对分数,表明了模型在多模态的环境中是有效的。

除此以外,这篇工作也开源了相关的代码和一个简洁高质量的中文多模态指令数据集,帮助后续工作使用 X-LLM 的框架进行研究,项目的主页与论文地址以下:X-LLM: Bootstrapping Advanced Large Language Models by Treating Multi-Modalities as Foreign Languageshttps://arxiv.org/pdf/2305.04160.pdf

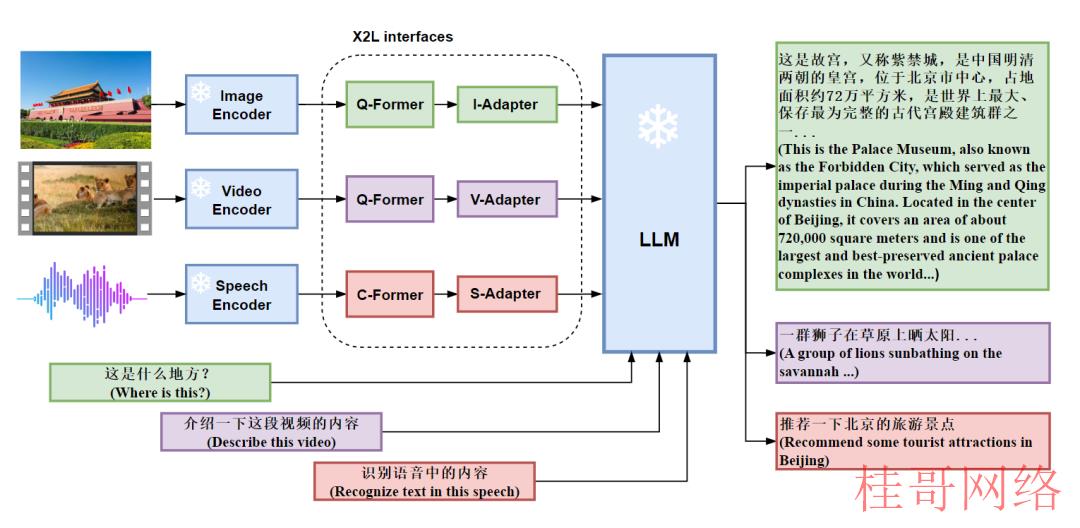

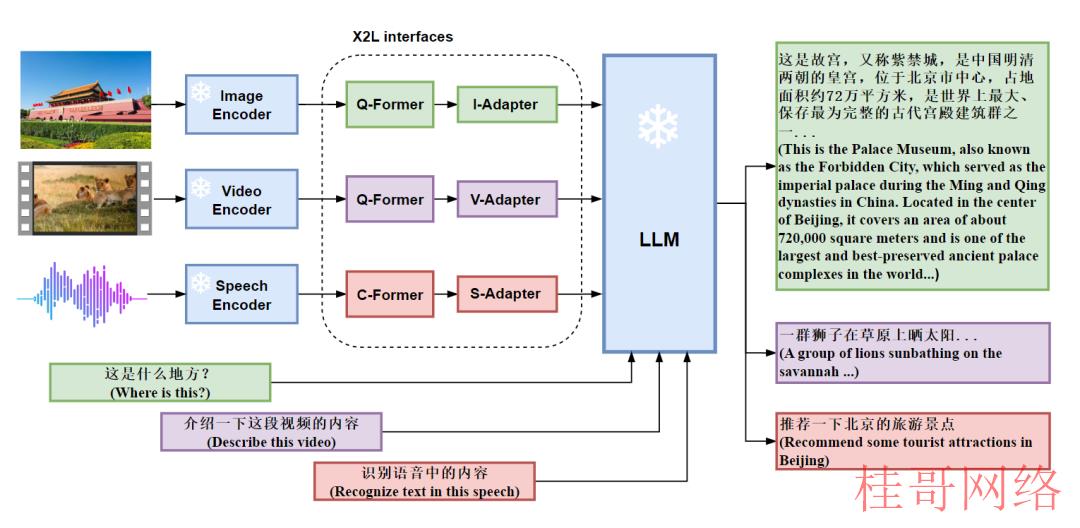

在进入论文之前,首先来想一想一个问题,GPT⑷ 是如何取得其强大的多模态能力的呢?论文作者给出了一个假定:“GPT⑷ 的多模态能力来源于其更先进,更大的语音模型,即 GPT⑷ 是用语言的情势表达出了其他模态的内容”。这个假定也就是讲,需要将多模态的数据“对齐”到语言数据当中,然后再投入大模型以取得多模态能力,在这个假定的基础上,作者提出了 X2L 接口,其中 X 意味着多模态数据,而 L 则表示语言,X2L 接口行将多个单模态编码器与一个大范围语言模型(LLM)进行对齐。其中,图象接口 I2L 采取 BLIP⑵ 中的 Q-Former,视频接口 V2L 复用图象接口的参数,但是斟酌了编码后的视频特点,语言接口 S2L 采取 CIF 与 Transformer 结构将语音转换为语言。全部 X-LLM 的训练包括三个阶段,分别是(1)转换多模态信息;(2)将 X2L 对齐到 LLM;(3)将多模态数据整合到 LLM 中。

- 图象接口:图象接口由 Q-Formers 和 I-Adapter 模块组成。Q-Formers的目标是将图象转换为语言,将从图象编码器取得的图象特点转换为长度为 L 的准语言嵌入的序列。I-Adapter 模块旨在对齐准语言嵌入的维数和 LLM 的嵌入维数;

- 视频接口:视频接口与图象接口采取相同的结构,并且均匀采样使用 T 帧表示每一个视频,再将每帧视频视为图象,构建长度为 T x L 的准语言嵌入序列;

- 语言接口:语音接口由两部份组成,即 C-Former 和 S-Adaptor。C-Former 是 CIF 模块和 12 层 Transformer 模块的组合。CIF 模块通过变长下采样将语音编码器的语音特点序列紧缩为相同长度的令牌级语音嵌入序列,而 Transformer 结构为令牌级语音嵌入提供了更强的上下文建模。S-Adaptor 用于将 Transformer 结构的输出投影到 LLM 的输入向量空间,从而进一步缩小了语音与语言之间的差距。

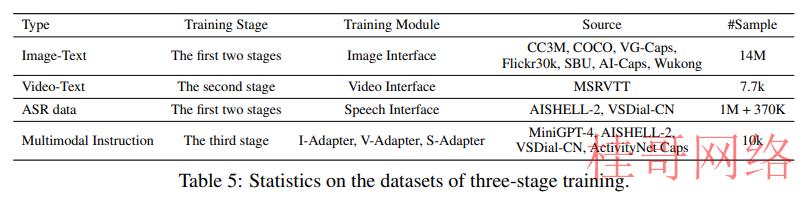

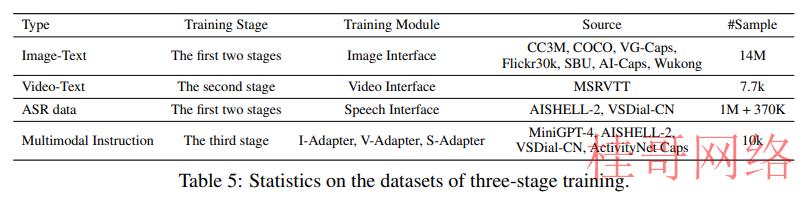

而在第二阶段,Q-Former 的参数来源于 BLIP2 中的 Q-Former 的参数。为了使得 Q-Former 适应中文 LLM,作者们使用了一个总共包括约 1400 万个中文图片-文本对的数据集进行训练,并使用图片中训练好的接口初始化视频中的 Q-Former 和 V-Adapter,最后,使用 ASR 数据训练语音接口,使语音界面的输出与 LLM 对齐。在全部进程中,Encoder 部份与 LLM 部份都不参与训练,只有接口部份进行训练。而最后第三阶段,论文使用多模态联合训练增强 X-LLM 的多模态能力,但是可以看到,在没有进行联合训练时,X-LLM 已具有了辨认多模态的能力,这类能力很有多是来自于 LLM。而为了进行联合训练,作者构建了一个多模态指令数据集对接口进行微调,包括(1) 图象-文本指令数据,(2)语音-文本指令数据,(3) 视频-文本指令数据和 (4) 图象-文本-语音指令数据。全部数据集主要来源于 MiniGPT⑷(图象,3.5k)、AISHELL⑵(语音,2k)和 ActivityNet(视频,1k)。

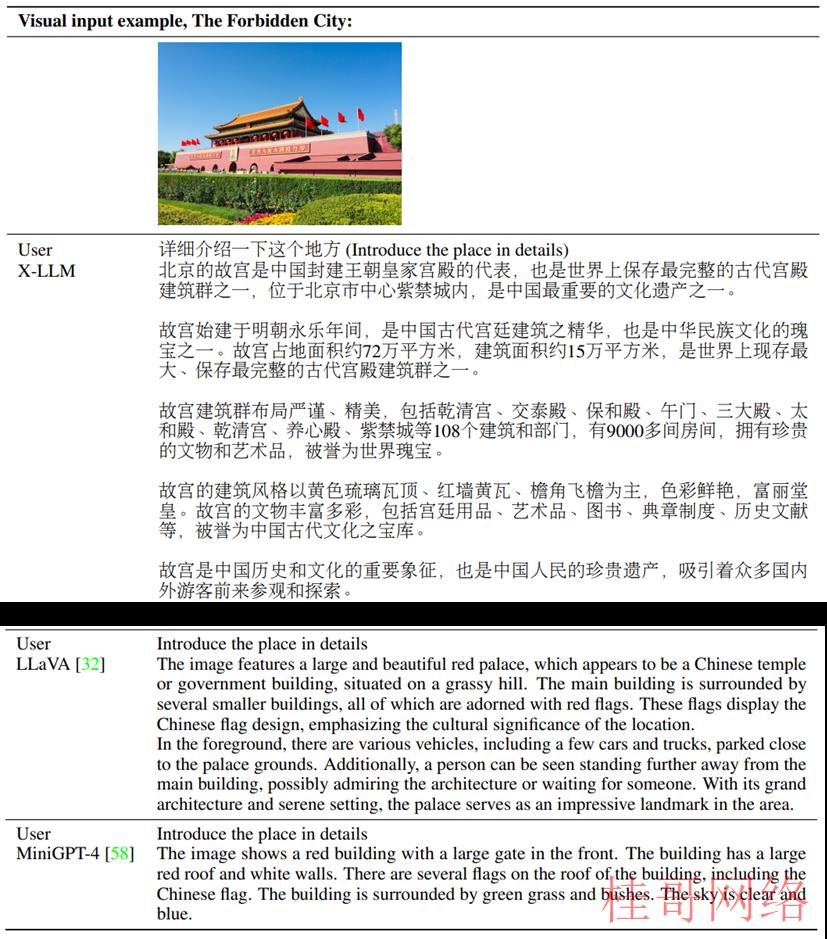

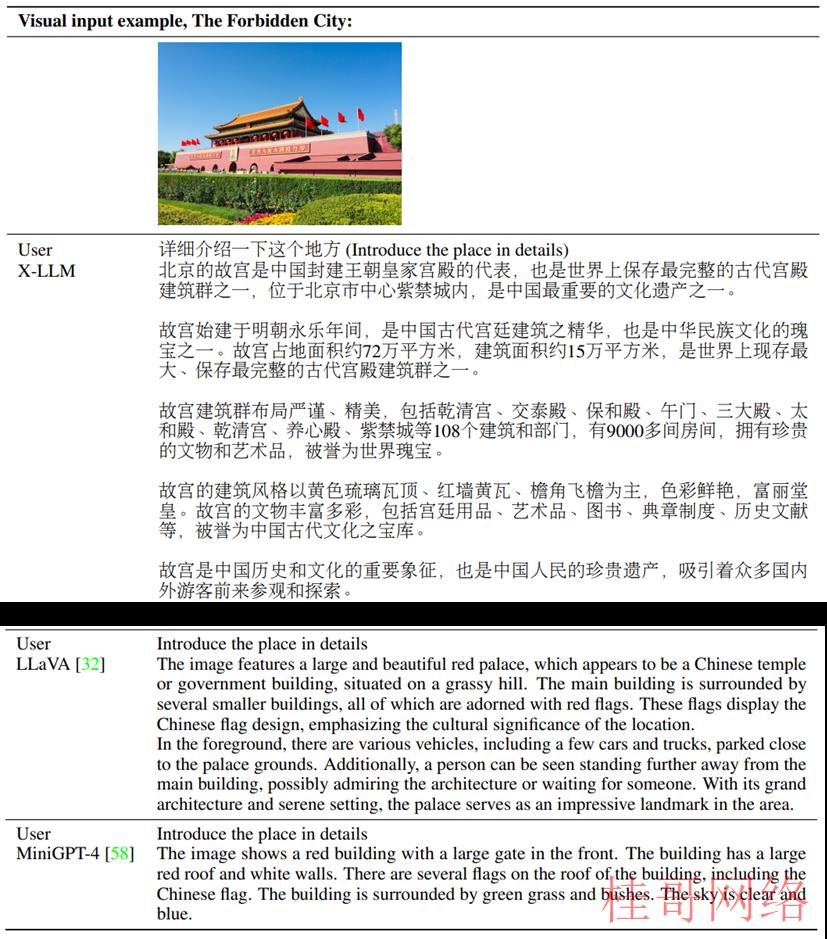

而在实验方面,论文作者开发了一个聊天界面,用以与其他开源的多模态大范围语言模型( LLaVA 与 MiniGPT⑷)做对照,整体而言,X-LLM 具有了相当不错的浏览和理解图片的能力,并且可以更好的捕捉其中具有“中国特点”的预感,以下图问答所示,当输入天安门的图片时,X-LLM 准确的辨认出了它是北京的故宫,并且给出了一些历史的介绍,而相应 LLaVA 与 MiniGPT⑷ 仅仅辨认出来了中国的宫殿和旗帜,但是并没有提到 Forbidden City。

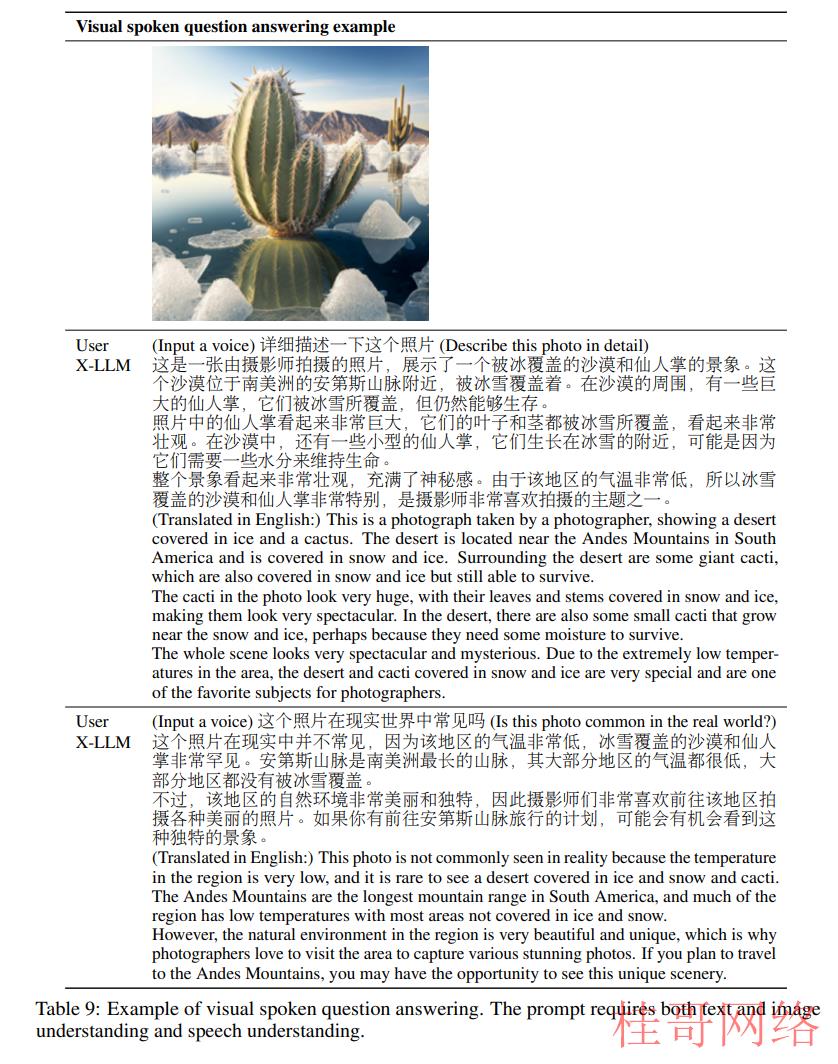

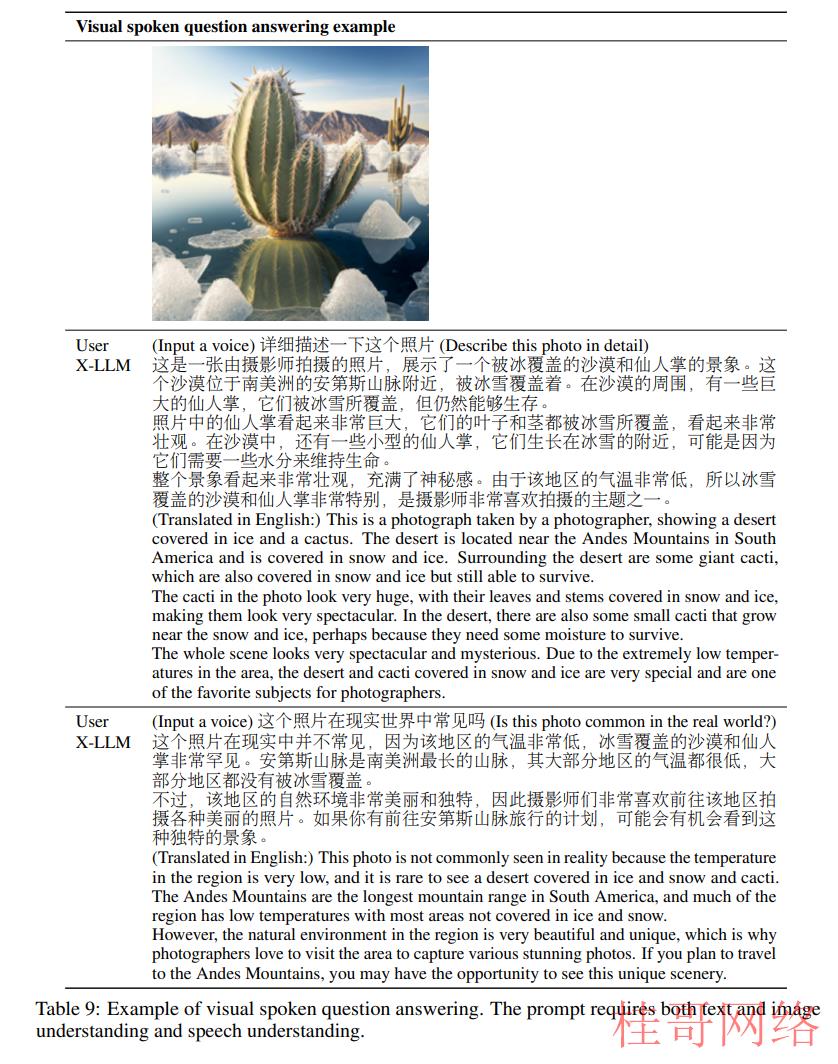

同时,X-LLM 也能准确的辨认和理解语音信息,这里的“详细描写一下这个“照片”是以语音情势进行的输入,可以看到 X-LLM 也能给出相当不错的回答,并且可以进行延申交换。

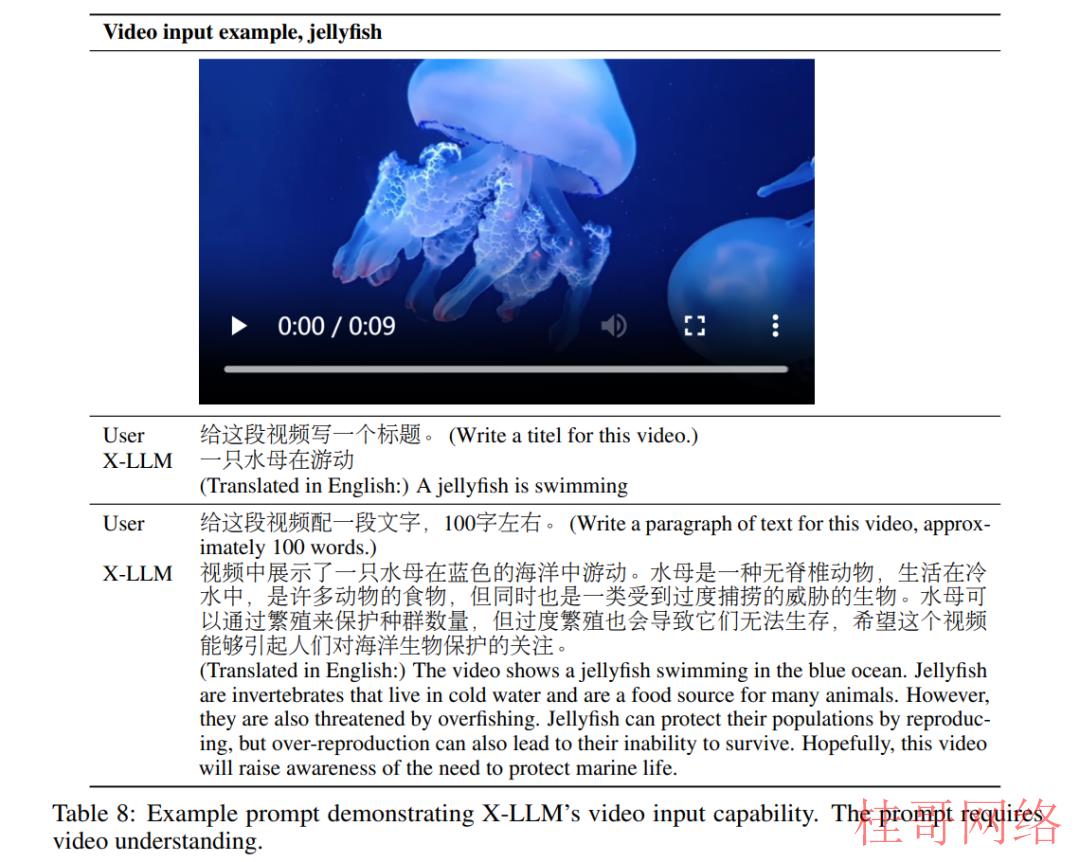

另外,在视频问答方面,X-LLM 也表现得相当不错,对输入的水母游动的视频,X-LLM 可以很是准确的为视频做出标题,并配以文字。

除 X-LLM 这样一个将大范围语音模型向多模态方向扎实推动了一步的框架外,作者也意外的发现,在英文数据集上训练的 Q-former 的参数可以转移到其他语言(汉语),并依然保持有效性。这类语言的可传递性极大地增加了使用英语图象文本数据和其训练的模型参数平移到其他语言中的可能性,并提高了在其他语言中训练多模态 LLM 的效力。透过这篇工作,也许我们可以一窥多模态大模型光明的未来,回到开头,多模型必定是 AGI 的必经之路,那末以语言为基准统一多模态可不可以实现呢?那就要看跟随这篇工作出现的未来了吧!

桂…哥…网…络www.gUIgeGe.cn

本文来源于chatgptplus账号购买平台,转载请注明出处:https://chatgpt.guigege.cn/jiaocheng/29651.html 咨询请加VX:muhuanidc